Déployer des outils de gestion des données de références (Master Data Management: MDM) est primordial pour le succès des initiatives data mais présente de nombreux défis. Nous partagerons notre vision sur la manière d'aborder ce type de sujet.

Nos recommandations pour prendre soin des assets les plus précieux que sont les Master Data tout au long de leur cycle de vie.

Notre analyste ne pouvant pas se permettre une telle attente, au risque de faire perdre un client à l’entreprise, va donc prendre sa décision en se reposant sur son intuition au lieu de pouvoir faire confiance aux données, et espérer que son intuition soit juste.

Ce scénario comme tant d’autres scénarios similaires dans toutes les entreprises manipulant des données au quotidien, illustre le manque de gestion des données référentielles (exemple: les données clients), le fameux Master Data Management.

Les Master Data sont les actifs clés autour desquels s’articulent les activités de l’entreprise et sur lesquels reposent un grand nombre de décisions. C’est à cet effet que leur gestion revêt une importance capitale.

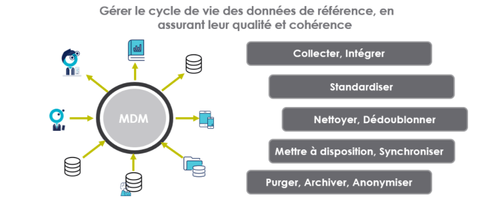

Cette gestion, appelée Master Data Management, consiste à gérer l'intégralité du cycle de vie de la donnée de référence tout en assurant sa qualité.

Les outils MDM permettent de tracer la donnée et de contrôler leur utilisation : c’est notamment très important d’un point de vue réglementaire (exemple : GDPR).

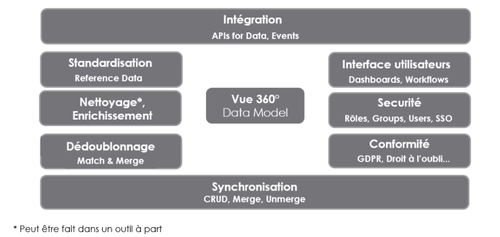

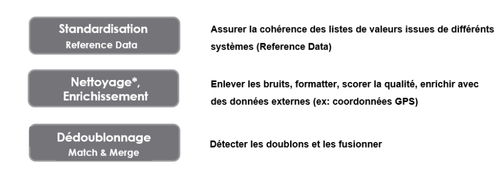

Qu’il s’agisse d’une solution éditeur ou d’une solution custom, un outil MDM sera constitué des modules permettant d’assurer les fonctionnalités suivantes :

En effet, il est difficile d’aligner les différentes parties prenantes de l’entreprise sur des définitions communes, des seuils de qualité partagés et sur le choix des valeurs de référence à utiliser. Se pose aussi la question du niveau auquel ces opérations de mise en qualité doivent être effectuées et via quels outils (directement dans le MDM, via un outil de Data Quality Management) ?

Le dédoublonnage, en plus d’être un processus long, est aussi un exercice périlleux où le défi métier consiste à trouver le bon équilibre entre les faux positifs (les doublons non détectés) et les faux négatifs (les données recensées à tort comme étant des doublons).

Au niveau spécifique du dédoublonnage, nos recommandations sont :

La synchronisation est un enjeu majeur du MDM : tout ce qui se passe au niveau du MDM doit être reflété dans les systèmes avec lesquels il se synchronise, qu’il s’agisse des systèmes consommateurs de ces données ou des systèmes producteurs de ces données. Cela suggère que la définition de l’architecture MDM est un sujet d’architecture d’entreprise continuellement mis à jour pour assurer l’alignement des données référentielles avec l’ensemble des systèmes.

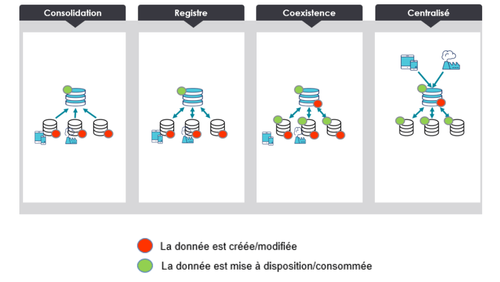

Il existe plusieurs modèles d'intégration d’un MDM qui diffèrent principalement par les points de création et de consommation de la donnée. Bien identifier les différents éléments producteurs et consommateurs de données est un prérequis indispensable à la mise en place d’un MDM.

Le Gartner (lien) référence quatre modèles distincts d’intégration d’un MDM.

Modèle adapté au cas d’usage analytique.

Modèle adapté à des fins de dédoublonnage principalement, la gestion des autres aspects de la qualité de données se fait au niveau des sources de données.

Modèle adapté aux situations où la qualité doit être gérée en central, la donnée continue à être produite par les sources, qui doivent et peuvent être synchronisées avec la version “golden” produite par le MDM.

Modèle adapté à la situation où nous pouvons faire du MDM l’unique point de modification de la donnée.

Le choix de l’architecture MDM à mettre en place doit être dicté par les cas d’usages MDM. L’architecture MDM n’est pas quelque chose de nécessairement figé : nous constatons bien souvent une évolution de cette dernière pour suivre les changements de l’organisation de l’entreprise et des cas d’usages.

L’approche en méthodologie agile et la priorisation des cas d’usage vous permettront de vérifier rapidement si les choix faits en termes d’architecture MDM répondent bien aux besoins ciblés par les cas d’usage et satisfont les utilisateurs/consommateurs de données.

L’agilité, au travers des différentes itérations et expérimentations de vos projets MDM et l’apparition de nouveaux cas d’usages, vous donneront de précieux renseignements pour faire évoluer votre architecture MDM.

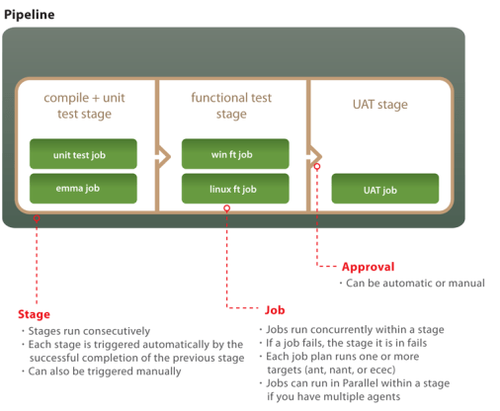

Utilisez les dernières tendances de l’IA, du machine learning et du DevOps comme des accélérateurs pour vos projets MDM.

Exemples :

Que ce soit à travers la définition des cas d’usage, les opérations de mise en qualité de données ou la création de tableaux de bord, il est nécessaire d’impliquer les utilisateurs car ils seront les utilisateurs du MDM. Embarquer et communiquer auprès des utilisateurs sur le MDM permettra de les sensibiliser et de diffuser une culture data au sein de l’entreprise.